Table des matières :

IA Explicable (XAI) : l'impératif de transparence algorithmique

L'IA explicable (XAI) transforme radicalement la manière dont les organisations déploient leurs systèmes d'intelligence artificielle, en rendant leurs décisions compréhensibles et justifiables.

Prêt à transformer votre entreprise avec l'IA ?

Découvrez comment l'IA peut transformer votre entreprise et améliorer votre productivité.

Mais comment concilier performance et transparence dans des modèles toujours plus complexes ? Comment répondre aux exigences réglementaires tout en préservant l’innovation ? Cet article vous guide à travers les enjeux, technologies et meilleures pratiques de l’IA explicable, désormais incontournable pour structurer un cadre de pilotage de l’IA aligné avec les principes éthiques et réglementaires.

Qu'est-ce que l'IA explicable (XAI) ?

L'IA explicable représente un ensemble de méthodes et techniques visant à rendre les décisions des systèmes d'intelligence artificielle compréhensibles par les humains. Contrairement aux approches traditionnelles où le fonctionnement interne des algorithmes reste opaque, la XAI dévoile le "pourquoi" et le "comment" des prédictions algorithmiques.

Principes fondamentaux

L'IA explicable repose sur quatre piliers essentiels :

- Transparence : Capacité à comprendre le fonctionnement interne du modèle

- Interprétabilité : Possibilité d'expliquer les décisions en termes compréhensibles

- Justifiabilité : Démonstration du raisonnement derrière chaque prédiction

- Auditabilité : Traçabilité complète du processus décisionnel

Comme le souligne un rapport du CESE : "L'explicabilité n'est pas seulement une exigence technique, mais un impératif éthique qui conditionne l'acceptabilité sociale de l'IA."

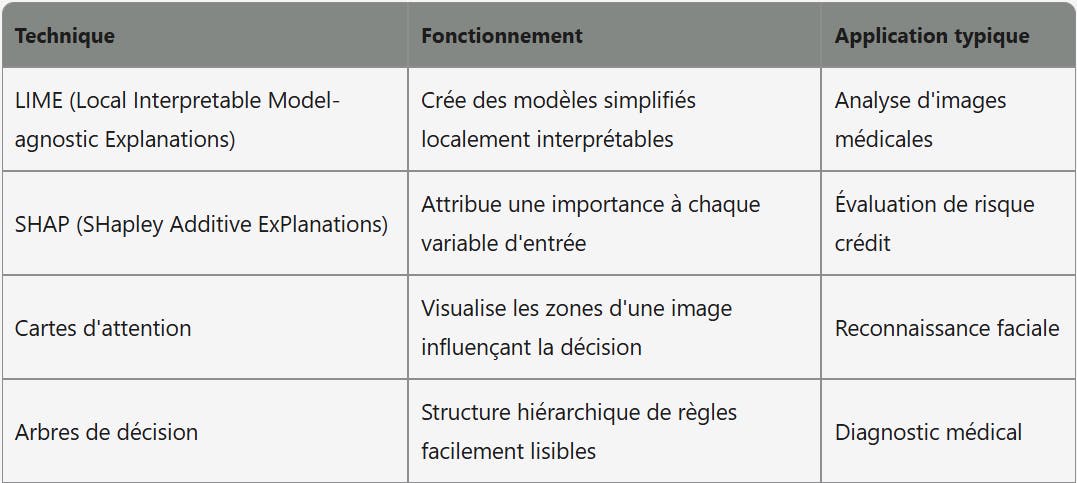

Méthodes et techniques clés

Plusieurs approches techniques permettent d'atteindre ces objectifs d'explicabilité :

Ces méthodes permettent de transformer des modèles complexes comme les réseaux neuronaux profonds en systèmes dont les décisions peuvent être expliquées et comprises par différentes parties prenantes.

L'EU AI Act et ses mplications pour la XAI

L'Union Européenne a adopté en 2024 le premier cadre réglementaire complet au monde dédié à l'intelligence artificielle, avec des exigences strictes concernant l'explicabilité des systèmes.

Approche basée sur les risques

L'EU AI Act catégorise les systèmes d'IA selon quatre niveaux de risque, chacun impliquant des obligations différentes en matière d'explicabilité :

- Risque inacceptable : Systèmes interdits (ex. : notation sociale)

- Risque élevé : Exigences strictes de transparence et d'explicabilité (ex. : recrutement, crédit)

- Risque limité : Obligations d'information (ex. : chatbots)

- Risque minimal : Pas d'exigences spécifiques

Pour les systèmes à haut risque, qui concernent de nombreuses applications business critiques, les exigences incluent :

- Documentation détaillée des méthodes d'entraînement

- Traçabilité complète des décisions

- Capacité à fournir des explications significatives aux utilisateurs

- Supervision humaine effective

Calendrier de mise en conformité

Les entreprises doivent respecter un calendrier précis pour se conformer à ces nouvelles exigences :

- Juin 2024 : Entrée en vigueur de l'EU AI Act

- Décembre 2024 : Application des interdictions pour les systèmes à risque inacceptable

- Juin 2025 : Mise en œuvre des obligations pour les systèmes à risque élevé

- Juin 2026 : Application complète de toutes les dispositions

Cette mise en œuvre progressive donne aux entreprises le temps nécessaire pour adapter leurs systèmes d'IA, mais exige une planification rigoureuse.

Applications sectorielles de l'IA explicable

L'adoption de la XAI transforme déjà profondément plusieurs secteurs clés.

Finance et assurance

Dans le secteur financier, l'IA explicable répond à des enjeux critiques :

- Octroi de crédit : Justification des refus de prêt conformément aux exigences réglementaires

- Détection de fraude : Explication des alertes pour réduire les faux positifs

- Évaluation des risques : Transparence des modèles actuariels pour les régulateurs

Une grande banque européenne a réduit de 30% ses contestations de décisions de crédit en implémentant des modèles SHAP pour expliquer chaque refus de manière personnalisée.

Santé et médecine

Le domaine médical, particulièrement sensible, bénéficie largement de la XAI :

- Aide au diagnostic : Explication des facteurs influençant les prédictions de pathologies

- Imagerie médicale : Mise en évidence des zones d'intérêt dans les radiographies

- Personnalisation thérapeutique : Justification des recommandations de traitement

Google DeepMind a développé des systèmes de détection de maladies oculaires utilisant des cartes de saillance pour mettre en évidence les anomalies détectées, permettant aux ophtalmologistes de comprendre et valider les diagnostics proposés.

Ressources humaines

Le recrutement et la gestion des talents évoluent avec l'IA explicable :

- Présélection de CV : Transparence des critères de filtrage

- Évaluation des performances : Justification des notations automatisées

- Prévision d'attrition : Explication des facteurs de risque identifiés

Une étude montre que les candidats acceptent 42% plus favorablement les refus d'embauche lorsqu'une explication claire et personnalisée leur est fournie.

Implémentation réussie : guide pratique

Déployer efficacement l'IA explicable nécessite une approche structurée.

Évaluation des besoins d'explicabilité

La première étape consiste à déterminer le niveau d'explicabilité requis :

Cartographier vos systèmes d'IA selon leur impact :

- Criticité des décisions

- Cadre réglementaire applicable

- Attentes des utilisateurs

- Sensibilité des données traitées

Définir les audiences pour les explications :

- Utilisateurs finaux (langage simple)

- Experts métier (terminologie spécialisée)

- Régulateurs (conformité technique)

- Développeurs (diagnostics techniques)

Établir des métriques d'explicabilité :

- Compréhensibilité (tests utilisateurs)

- Fidélité (correspondance avec le modèle original)

- Cohérence (stabilité des explications)

Choix technologiques adaptés

Plusieurs approches techniques peuvent être combinées :

- Modèles intrinsèquement interprétables (arbres de décision, règles) pour les cas d'usage simples

- Méthodes post-hoc (LIME, SHAP) pour les modèles complexes existants

- Architectures hybrides combinant performance et explicabilité

Les frameworks open-source comme AIX360 (IBM), InterpretML (Microsoft) ou SHAP facilitent l'implémentation de ces techniques sans réinventer la roue.

Gouvernance et documentation

Un cadre de gouvernance solide est indispensable :

- Registre des modèles documentant les choix d'explicabilité

- Processus de validation des explications par des experts métier

- Tests réguliers de la qualité des explications

- Documentation exhaustive pour les audits réglementaires

Défis et considérations

Malgré son potentiel, l'IA explicable présente des défis significatifs.

Compromis performance/explicabilité

L'un des principaux défis reste l'équilibre entre performance et transparence :

- Perte de précision : Les modèles plus simples et explicables peuvent sacrifier 8-12% de précision

- Surcharge cognitive : Trop d'explications peuvent submerger les utilisateurs

- Coût computationnel : Certaines méthodes d'explicabilité augmentent significativement les ressources nécessaires

Les approches hybrides, combinant des modèles performants "black-box" avec des couches d'explication, émergent comme solutions de compromis.

Enjeux éthiques persistants

L'explicabilité ne résout pas tous les problèmes éthiques :

- Biais algorithmiques : Une décision explicable peut rester biaisée

- Manipulation des explications : Risque de justifications trompeuses

- Fausse confiance : Des explications simplistes peuvent induire une confiance excessive

Une approche holistique de l'IA éthique doit compléter les efforts d'explicabilité.

L'avenir de l'IA explicable

Les perspectives d'évolution à court et moyen terme sont prometteuses.

Tendances émergentes

Plusieurs tendances façonneront l'avenir de la XAI :

- Explicabilité multimodale pour les systèmes traitant simultanément texte, image et son

- Personnalisation des explications selon le profil et les besoins de l'utilisateur

- Explicabilité collaborative impliquant humains et IA dans la construction des explications

- Standardisation des méthodes avec l'adoption de normes ISO spécifiques à la XAI

Perspectives sectorielles

D'ici 2026, selon les analystes :

- 85% des applications financières intégreront des fonctionnalités XAI natives

- 50% des systèmes médicaux fourniront des explications adaptées aux patients

- 30% des entreprises adopteront des politiques d'IA "explicable par défaut"

L'IA explicable n'est plus une option mais une nécessité stratégique dans l'écosystème technologique actuel. Au-delà de la simple conformité réglementaire, elle représente un levier de confiance et d'adoption pour les systèmes d'intelligence artificielle.

Pour les organisations, le défi consiste désormais à intégrer l'explicabilité dès la conception des systèmes d'IA, plutôt que comme une couche superficielle ajoutée a posteriori. Cette logique « explicabilité by design » s’impose progressivement comme un critère différenciant dans les stratégies d’IA souveraine au service des collectivités, où chaque décision automatisée doit pouvoir être comprise, auditée et justifiée.

À mesure que la confiance devient un actif stratégique, l’IA explicable s’affirme comme le lien essentiel entre innovation technologique et acceptabilité sociale. Les acteurs capables d’aligner transparence, performance et gouvernance responsable transforment ainsi une contrainte réglementaire en véritable levier de compétitivité numérique.

author

OSNI

Publié

mars 20, 2025

Prêt à transformer votre entreprise avec l'IA ?

Découvrez comment l'IA peut transformer votre entreprise et améliorer votre productivité.